这不是一篇普通的博客文章。今天,我们为您带来的是一个简短的视频教程。🎥

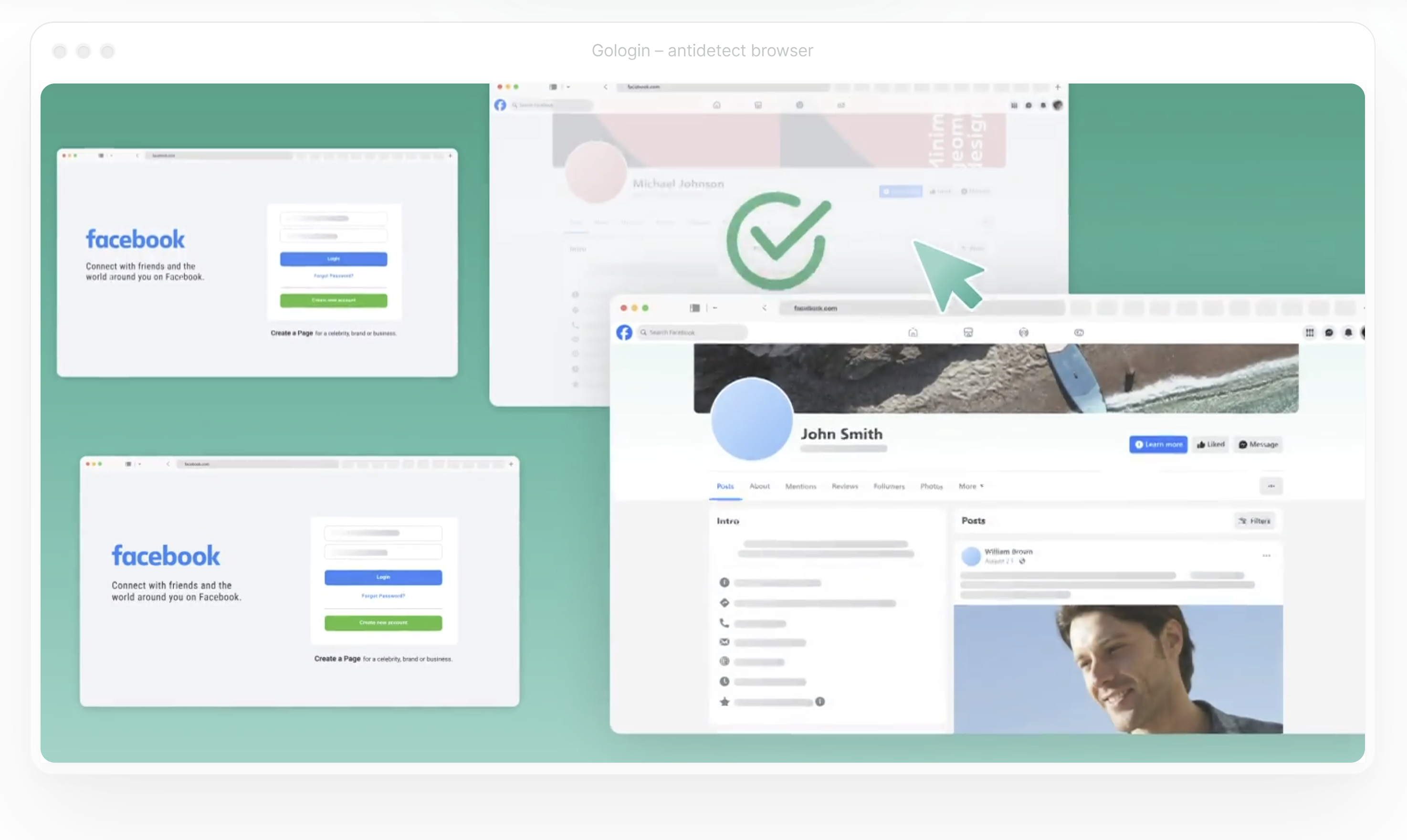

在本视频中,我们将逐步指导您在Gologin中设置代理。您将学习如何连接到可靠的代理(使用 ProxyScrape 作为示例),测试配置效果,并实现匿名浏览会话。

作者:ProxyScrape2025年10月15日

这不是一篇普通的博客文章。今天,我们为您带来的是一个简短的视频教程。🎥

在本视频中,我们将逐步指导您在Gologin中设置代理。您将学习如何连接到可靠的代理(使用 ProxyScrape 作为示例),测试配置效果,并实现匿名浏览会话。

作者:ProxyScrape2025年2月21日

如果你是Python和网页抓取的新手,很可能已经接触过"Pandas"这个术语。但Pandas究竟是什么?为何它在数据分析与提取领域如此重要?本指南将带你循序渐进,从零基础逐步成长为自信的Pandas用户。 读完本文,你将理解Pandas强大的核心优势,并掌握如何运用它高效处理抓取数据。

作者:ProxyScrape2025年2月14日

在本指南中,我们将逐步指导您在macOS系统上配置代理。我们将重点介绍如何集成 ProxyScrape ,确保您的连接安全可靠,并针对各类使用场景进行优化。完成配置后,您还将学会如何测试代理设置,以确认流量已正确路由。

开始吧!

作者:ProxyScrape2025年2月7日

网站地图通过提供网站希望搜索引擎收录的结构化URL列表,在搜索引擎优化和网页爬取过程中发挥着关键作用。相较于逐页追踪链接爬取网站,通过网站地图进行爬取能更高效地发现所有可用URL。

作者:ProxyScrape2025

网页抓取是开发人员、数据分析师和SEO专业人士的重要工具。无论是收集竞争对手情报还是编译数据集,抓取过程往往需要浏览多页数据——这被称为分页。然而,尽管分页对用户体验至关重要,它却给网页抓取带来了重大挑战。

作者:ProxyScrape2025

网络爬虫已成为从互联网收集数据不可或缺的工具,助力数据分析师、技术爱好者和企业做出明智决策。但数据提取仅是第一步。要充分释放其潜力,必须高效地将其导出为合适的格式——无论是用于电子表格的CSV文件、用于API的 JSON格式,还是用于大规模存储与分析的数据库。

本博客将带您了解网络爬取数据导出的核心要点。您将逐步学习如何处理CSV和JSON文件、将网络爬取数据与数据库集成,并最大化提升您的数据管理实践。

作者:ProxyScrape2024年12月25日

网络爬虫已成为开发人员和数据分析师从网络中提取和分析信息的重要工具。无论是追踪产品价格、收集研究数据,还是构建定制化仪表盘,网络爬虫都能提供无限可能。